2018年8月30日

拡張現実(AR)ロボット工学

(2018-06-20)by Ryan Hickman

本記事は、原著者の許諾のもとに翻訳・掲載しております。

火星探査の車両もあなたのスマートフォンも同じ問題を抱えています。GPSなしの位置特定です。

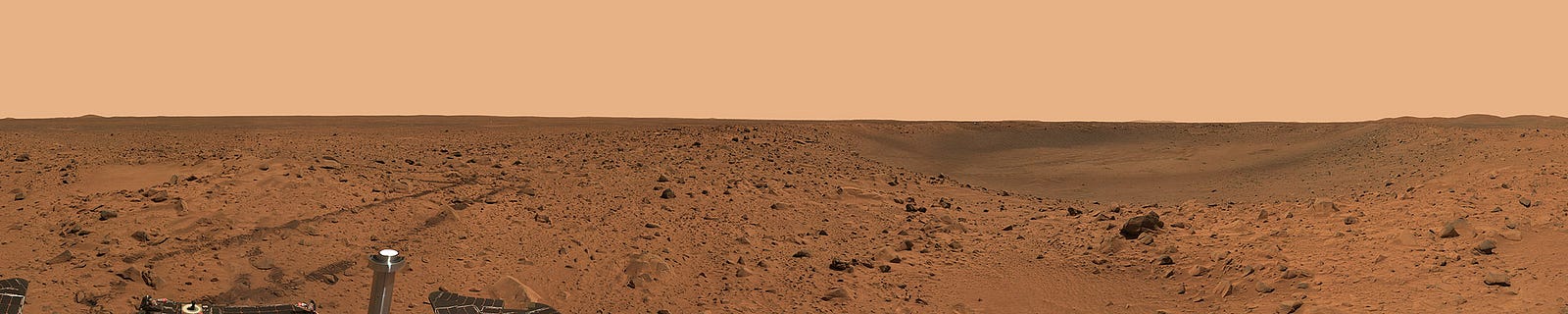

火星探査車スピリットによるボンネビル・クレーターのパノラマ。出典:NASA/ジェット推進研究所/Cornell

ショッピングモールや地下駐車場、あるいは高層ビルの谷間のどこであれ、空の見えない場所では携帯電話のGPSが使いものになりません。視覚オドメトリなどの技術を使い時間をかけて動きをたどる他の惑星上のロボットにも同じことが当てはまります。

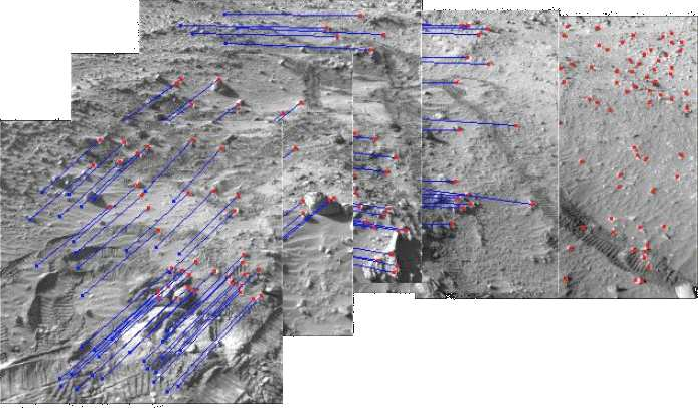

スピリットのカメラで追跡したフィーチャを重ねた写真。出典:”Two Years of Visual Odometry on the Mars Exploration Rovers(火星探査車ローバーによる視覚オドメトリの2年間)”(NASAジェット推進研究所 Mark Maimone, Yang Cheng, Larry Matthies)

視覚オドメトリは数十年前に登場した技術ですが、モバイル機器の拡張現実で日の目を見ました。Visual Inertial Odometry on the Mars Exploration Rovers(火星探査車ローバーによる視覚慣性オドメトリ)を使った Larry Matthiesの名前がある参考文献 を見てください。意外でも何でもないことに、NASAジェット推進研究所にある彼の研究室はスマートフォンに同じ機能を持たせようとしていたGoogleの Tangoプロジェクト の初期に参加していました。当時は同じくジェット推進研究所にいて現在Googleで働くSteve Goldbergは 火星探査車両用 の視覚オドメトリのパイプラインを最適化した数少ない1人と断言できる人物であり、あなたのスマートフォンでARを動かした人です。

ジェット推進研究所の探査車やTango(現在はARCore)が使っている更に高度なレベルの技術は SLAM またはSimultaneous Localization and Mapping(自己位置推定と環境地図作成の同時実行)と称されています。もっと厳密に言えば、使っているのは VSLAM とVIOであり、その技術ではカメラとモーションセンサーが一緒になって視覚慣性オドメトリを作っています。人間の目と耳が一緒に働くように、ロボットや拡張現実のデバイスはカメラとモーションセンサーが使われています。

バーチャルのネコが不十分な動き

多くのロボットが自分の位置を認識するだけで多くのことをこなしますが、自動運転車のようなもっと複雑なシステムは、位置だけでなく更に複雑な世界を認識する必要があります。もし仮想の物体を単に地面に置くこと以上のエクスペリエンスを目指すなら、同じことが拡張現実にも当てはまります。

実際、 バーチャルのネコが思わぬ動きをして、ARとロボット工学の将来が何と似ていることかと非常にショックを受けました。 位置情報だけでは不十分なのです。

ガラスドアの向こうでバーチャルのネコを歩かせたら、通り抜けてきました。

Tangoの”ARペットエクスペリメント”アプリで、バーチャルのネコがドアのガラス窓を通り抜けます。Tangoのスマートフォンの赤外線TOF深度センサーがガラスを検知していませんし、ドアの枠にガラスがあるはずと仮定するAIもありませんでした。

誰かが画面に入ってきて私のバーチャルのネコを踏みつけていきました。

Tangoの”ARペットエクスペリメント”のもう1つのデモでは、アニメのかわいらしいネコが停止している最中に誰かがその場に入ってきました。リアルタイムの追跡システムがなく、入ってきた人物の認識や経路の予測やARの映像を台無しにしないような回避ができません。

バーチャルのペットに「向こうへ行って、ふせ」と命じてみてください。何もしません。デジタルの生き物の未来像とされているバーチャルのキャラクターはいまだに世界を理解していません。キャラクターが頼るのは不完全なモバイルのセンサーで、 “光学的な処理が困難な表面” が苦手です。今でもARのデバイスは人間や動物の動きの認識や追跡や予測ができません。

作った映像はリアルに見えても何百もの方法で台無しにされ、同じ問題がロボットにも影響を与えています。私が欲しいのは、動作が素早くて我が家のドアのガラスを壊さないホームロボットです。部屋に入って、道を譲り損なったロボットに蹴つまずきたくありません。何事も口頭で指示し、現実の犬に行うように(例えば「おすわり」、「まて」」、「つけ」、「ふせ」、「おいで」)、自分がどこにいてもロボットに指示したいと思っています。

そのためには現在は存在しない空間的推論レベルのAIが必要です。この認識のもと、結局TickTockを作るに至りました。私たちの望みはバーチャルや現実のシステムに世界をもっとよく理解させることです。

やはり最初は位置情報の問題

Don Dodgeは2013年に、この領域に取り組んでいる 数十の会社をリストアップ しました。それから5年後の今もまだ、こうしたビーコンやWi-Fiオンリーのソリューションは実用化されていません。カメラを多用するARKitとARCoreを採用した会社が勝ち組になりそうです。 2018年に10億台以上のデバイスを動作させる と期待されるのは、この2つのプラットフォームだけです。

“ ARクラウド “が成長して、地図と、世界についてのセマンティクスをますます多く蓄えていくのにつれて、製品レベルのナビゲーションにセンチメートル単位の精度が期待されます。そう、 金物店で、スマートフォンがあなたを欲しいネジの場所にまで正しく連れて行ってくれる のです。

でも、ロボットには従来の地図フォーマットが使われています。

セントルイスの食料品店Schnucksの例を見てみましょう。 ロボットが在庫をチェックして回る一方で 、 拡張現実のショッピング体験には別のプラットフォームが使用されています 。これらは、同じ場所について別々の地図フォーマットを使っていて、システム間の不適合を引き起こし、地図を最新に保つために余分のメンテナンスも必要になります。

ARマッピングの分野には新しいスタートアップが一斉に参入し始めていて、 8th Wall やEscher( 現在は、Nianticのために世界をマッピングしています )、 6D.ai 、 Fantasmo は、どの会社も、ユーザが自分のいる位置を把握するために役立つ、位置情報サービスとクラウドAPIを提供しています。Googleは独自の立ち位置にいて、 Cartographer で使用されているようなLiDARマッピングと、Project Tango/AR Core/VPSの土台となるVSLAM向けのマッピングの両方を提供しています。

I/O 2017でのGoogleの視覚的位置情報サービスの発表を伝えるTechCrunchの動画。

Cartographerは2016年にオープンソース化され、またたく間にロボットのための卓越した2D/3Dマッピングソリューションとなり、歩道で荷物を配達する Marble をはじめ、自動運転車の自動化を手がける Lyftのレベル5ラボ などで採用されました。一方、GoogleのVPSと Cloud Anchors はLiDARベースのSLAMとは異なり、単純な2Dカメラを使用しています。つまり、このSLAMは、ハードウェアを追加することなくモバイルフォンで機能するということです。どちらもGoogle発でありながら、CartographerとVPSには現在のところ互換性がありません。それが問題なのです。なぜなら、TickTockには、スマートフォンでも機能するロボットナビゲーションシステムが必要だったからです。

AndroidベースのVSLAMに賭けたTickTock

私たちは、ユーザが使うことになるProject Tango/AR Core/VPSの地図と同じ地図を使って、Androidで実行するカスタムのロボット工学スタックの構築に着手しました。空間内の位置についての理解がロボットとスマートフォンの間で同じでなければならないユーザエクスペリエンスには、この共通基準系は不可欠です。

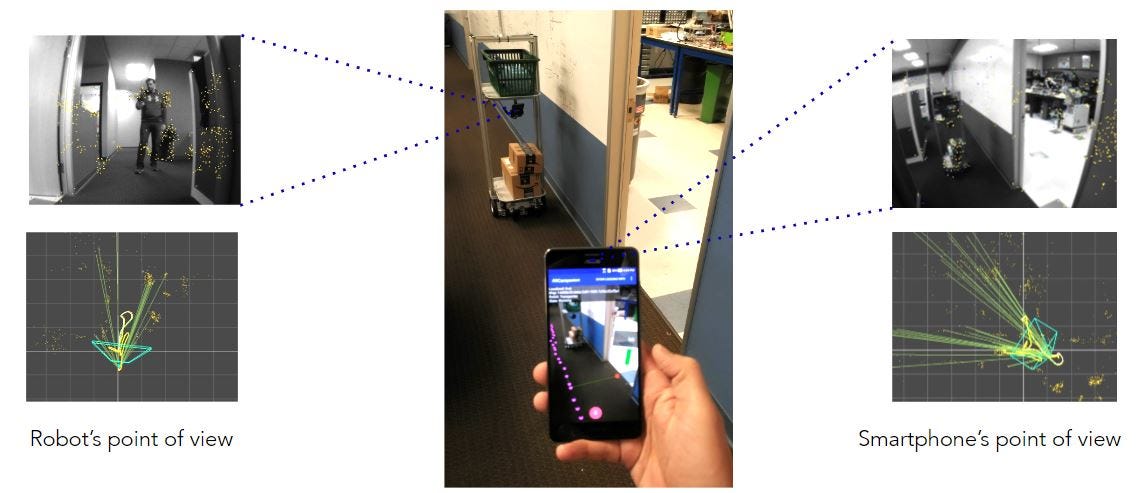

左側はロボットの視点で、壁とオブジェクトの固有の視覚的フィーチャ(特徴)を認識することによって、ロボットが世界の中で自分の位置を特定する様子を示します。ユーザが手に持ったスマートフォンは反対方向から同じことをして、ユーザが拡張現実の中で精密な位置決めコマンドをロボットに与えられるようにします。

私たちがTickTockに着手した2017年の初頭には、Project Tangoの事業がAR Coreとしてリブランディングされつつあり、VPSはまだベータ版でした。これは流動的な状態ではあっても前に進むための理想的な道筋でした。また、私たちはAndroidのOEMメーカーになったので、スマートフォンのメーカーが使うであろうコンポーネントと同じコンポーネントを使ってロボットを作ることができたのです。

この早期のデモ動画では、ARを使って、世界の中でのPOI(Point Of Interest:動作や処理、興味の対象となる地図上の特定のポイント)、ロボットの位置、ロボットが予定している移動経路を見ることができます。

TickTockの早期デモ:家庭内の小型移動ロボットで動作するTickTockソフトウェアと、それに指示を与える子ども。スマートフォンには、ロボットが世界について何を知っているかが、ARコンパニオンアプリを通して表示されています。

ARは、過去数十年間のロボット工学事業の恩恵を受けている

Tangoプログラムの一部として、合計5つのロボティックラボが参加していました。 ミネソタ大学のMARSラボのページ には、ドローンや火星探査機の研究に並び、Tangoのリファレンスの数々が挙げられています。 チューリッヒ工科大学のビジュアルコンピューティングラボ もまた、ビジュアルマッピングの分野で著しい進歩を遂げ、 Marc Pollefeysが現在、Microsoftのホロレンズの科学技術のディレクター になっているのは驚くにはあたりません。また、 インペリアル・カレッジ・ロンドン のAndrew Davidsonのチームからも早期に助言が得られ、 これらの技術の重なり合う部分 が、彼のバックグランドによって1つにまとめられました。

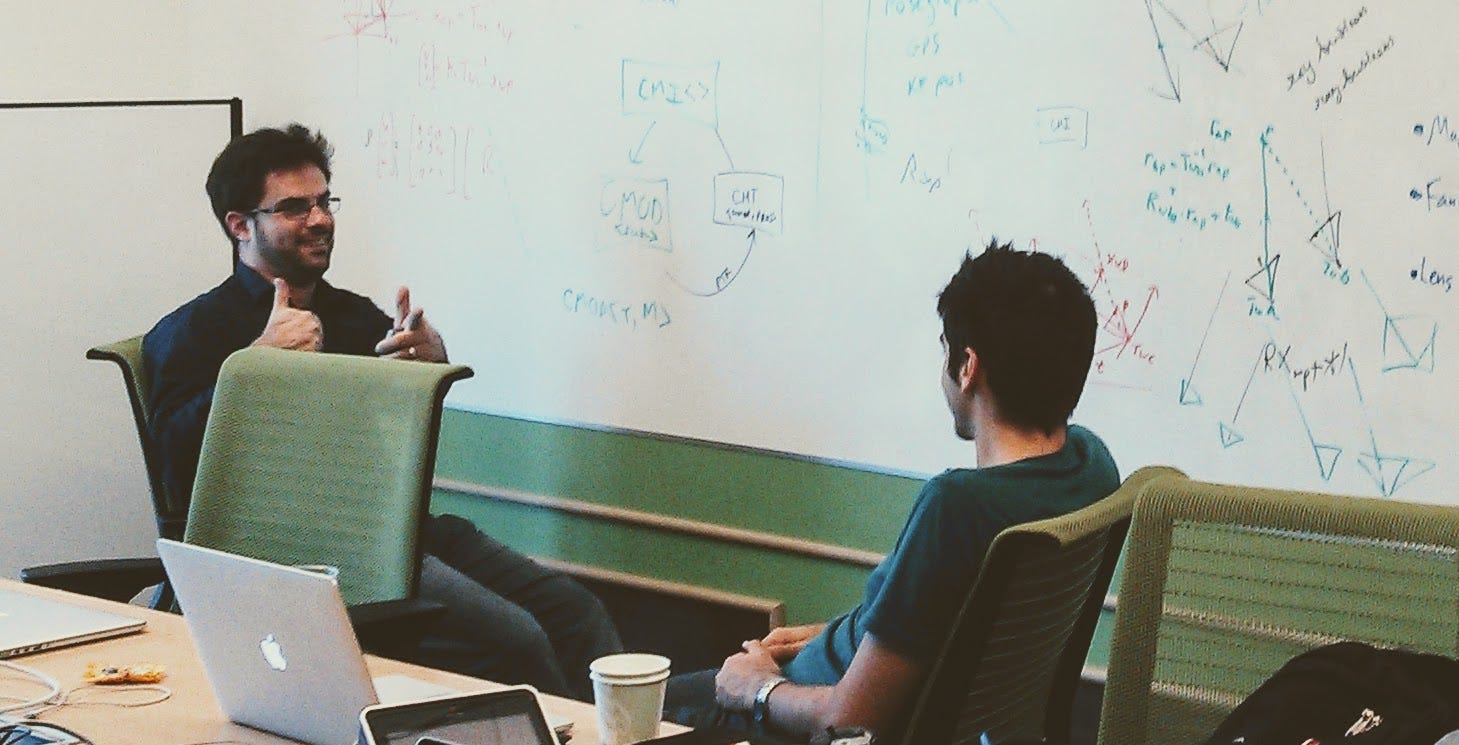

2013年、MotorolaのATAPオフィスで、早期のTangoのブレーンストーミングセッションを率いるJohnny Lee(右)。訪れた研究者には、JPLのLarry Mathies、UMNのStergios Roumeliotis、インペリアル・カレッジ・ロンドンのMarc Pollefeysがいます。

拡張現実、ロボット工学のスタートアップ、自動運転車の分野は、今後も互いに広く重なり合うでしょう。ジョージ・ワシントン大学(GWU)とコロラド大学のGabe SibleyのラボはどちらもARで有名で、2013年にTangoに協力しました。Gabeのラボの学生の1人、 Nima Keivan は、その後、 Canvas Technology を設立しました。この会社は、ROSやLiDARに基づくマッピングを使わないロボット工学の会社の1つです。

ビジュアルSLAMについてのアイデアの議論に決着をつけるために2013年の初頭にProject Tangoチームを訪問した、GWUの自律ロボット工学&認知ラボのGabe SibleyとNima Keivan。

Gabeは後にZippyを立ち上げ、 現在はCruise Automationの一部となって 、GMの自動運転車に空間把握能力を提供しています。関連ニュースによると、Zippyは Chris Broaddus 、 Alex Flint と共同で設立され、この2人はどちらも、Tangoに先がけた拡張現実の草分け的な会社、Flyby Mediaから参加しました。Flybyのチームは2013年にGoogleによるVSLAMソリューションの評価を支援し、 その後、Appleに買収され 、そこでiOS用のARKitを作り上げました。

OK、よく分かりました。ロボット工学は、ARに大きく役立ったのですね。では、ARはロボット工学のために何をしてきたのでしょうか。

ARが恩返しを始める

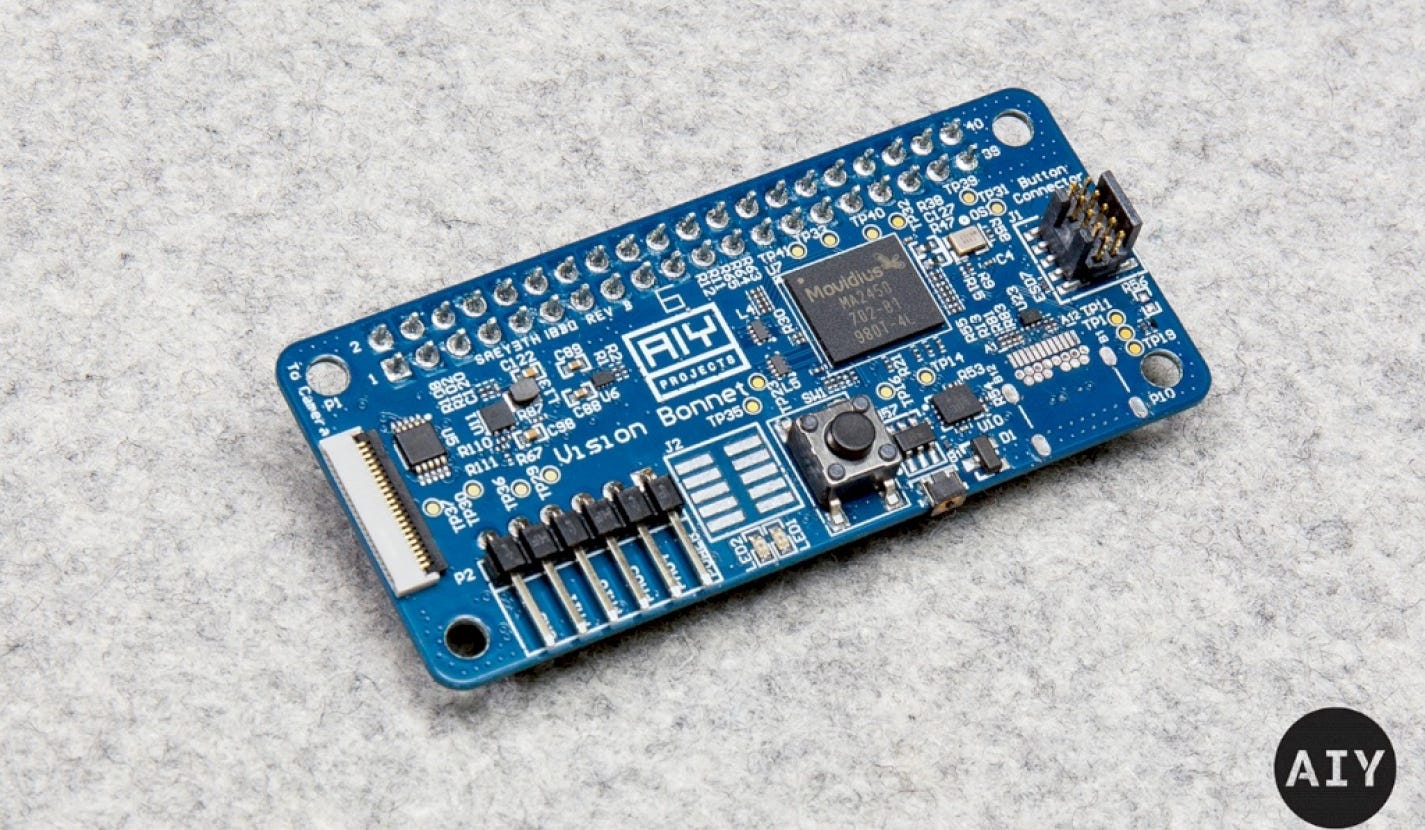

Movidius MyriadチップはARがロボット工学に役立っていることを示す一番の証しです。私たちは 初期のTango Teardown 5″ phone のプロトタイプ上でv1 Myriadを使い、MyriadのVision Processing Unit(VPU)を目指すという新しい考えに協同で取り組みました。今ではこれらのチップは、DJIのすばらしいドローンの原動力となり、安定した姿勢を保ち、木への衝突を回避します。GoogleとMovidius(現在はIntelの傘下)とは良い関係を保っており、最近 新しいDIY、というか、AIYキット を発売しました。AIYキットを使えば、この技術を活用するのがいっそう容易になります。

Googleの”Vision Bonnet”回路基板は、AIYプロジェクトの一部であり、Movidius Vision Processing Unit(VPU)を特徴づけるものです。

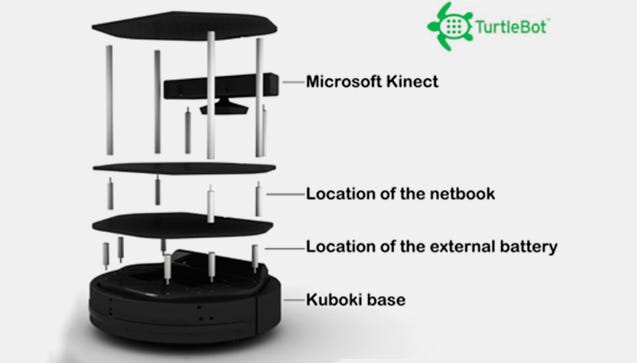

Microsoftはロボット工学にARテクノロジーを適用する分野においてかなり先行している先導者でした。X-Box 360用の画期的なKinectセンサーは2009年に発表され、またたく間に[深度センサーのコストを低減するためにロボット工学研究室により至る所で改変が行われました](https://ieeexplore.ieee.org/document/6236985)。2Dや3Dマップの作成、(当初の目的どおり)人の追跡、またTurtlebotやその他多くのロボットの物体認識の支援として使用されました。

MicrosoftのKinect 3D深度センサーは、上に示すブレイクアウトダイヤグラムのようなTurtlebotの第1、第2世代で最もよく利用されていました。これは通常は処理を行うLinuxのネットブックに接続されていました(図示はされていません)。

動きを追跡する3Dセンサーを備えたリビングルームの拡張はうまくいきませんでした。MicrosoftはKinectを取りやめ、結局[AIに特定した用途に戻す](https://developer.microsoft.com/en-us/perception)ことになりました。きっとロボット工学研究者もHoloLensが人と物を認識しながら部屋を地図に描くことを可能にする\[新しいHPU\](the newHPU(Holographic Processing Unit)(https://www.microsoft.com/en-us/research/blog/second-version-hololens-hpu-will-incorporate-ai-coprocessor-implementing-dnns/)を手に入れたいと思っています。これはロボットの夢のすべてです。

スタートアップが2つの世界を融合させる

Vitaliy Goncharuk もまたAugmented PixelsでARからロボット工学への移行を推進しています。 2014年のメディア報道 を見てください。それは、もっぱら買い物や不動産のARエクスペリエンスに着目していました。2017年までには、ロボットやAR/VR用ウェアラブルメガネの両方にSLAMを提供するモジュールを使用するために LGとの提携を発表 しました。同じ技術ですが2つのプラットフォームは全く異なります。

Augmented Pixelsと提携しているLEGのコンパクト3Dカメラのモジュール

今年の初めのCESで行われた、 頭部にOccipitalの構造コアセンサを備えた Misty 1 の発表からもほんの数カ月しかたっていません。ロボット工学とIoTに注力しているVC企業であるGrishin Roboticsからの支援も含め 2015年にOccipitalのシリーズBで14億4千万円を調達した のは驚くことではありません。AR/VRと同様にロボット工学にとって価値のあるものとして 同社のコアセンサは現在売り込まれています 。

Mistyのプロトタイプの頭部は、上部にOccipitalの構造コアセンサを表示しています。

他にもARをロボット工学に転用した起業家、Paracosmもまた ロボット工学畑

出身で Occipitalに買収される 前には Tango effortを支援していました 。

近年は、分散型マッピングプラットフォームでひそかに姿を現したばかりのFantasmoがおり、 発売を発表する際、使用事例としてロボット工学とARの両方を強調しています 。

ほんの数年のうちに、 iPadと車輪とモータだけで、高校生が自律型ロボットを作成するのを見ることになるだろう と思っています。ARCoreやARKit上のUnityで数時間プログラミングをするだけで、バーチャルのキャラクターと物理的キャラクターとが一緒になって動き回るのを目の当たりにするでしょう。

プラットフォーム戦争の誘因

“アレクサ、 廊下 の電気をつけて”、”TickTock、 廊下 に行って”といった命令では、音声認識が有効なガジェットやモバイルロボットが 廊下 はどこかということを理解する必要が生じます。もしかしたらロボットに家の地図を描かせ、増え続ける”ホームグラフ”を作り出すIoTガジェットの2Dリストを管理する代わりに、物がどこにあるのかを理解させる必要があるかもしれません。

Tangoの”Constructor Developer Tool”で作成した自宅の3Dマップ。ロボットは、同様のデータを保存して、家の中の物体と自分の位置を認識するためにデータ処理を行います。こういう類のデータを共有する標準はまだ存在していませんが、将来的には、全てのIoTプラットフォームの中核を成すでしょう。

Amazon、Apple、Facebook、Microsoftもクラウドマッピングのゲームに参入すると確信しています。そして このデータを保有する戦いになるに違いありません 。オープン標準が出現することはとても素晴らしいことです。そうすれば、ルンバがKuriやMistyロボットに話しかけることができるし、恐らく拡張現実で情報交換を行うことで、AndroidとiOSの両方で、エクスペリエンスを実行するでしょう。

数十年にも及ぶ技術の重複にもかかわらず、ロボット工学と拡張現実に関しては、製品のエクスペリエンスは全て生まれたばかりです。”ARクラウド”で何ができるかということにもっと注目してください。くだらないゲームに使われるだけのものではないからです。ロボットは拡張現実を必要とするでしょう。ARはロボット工学を必要としているのです。